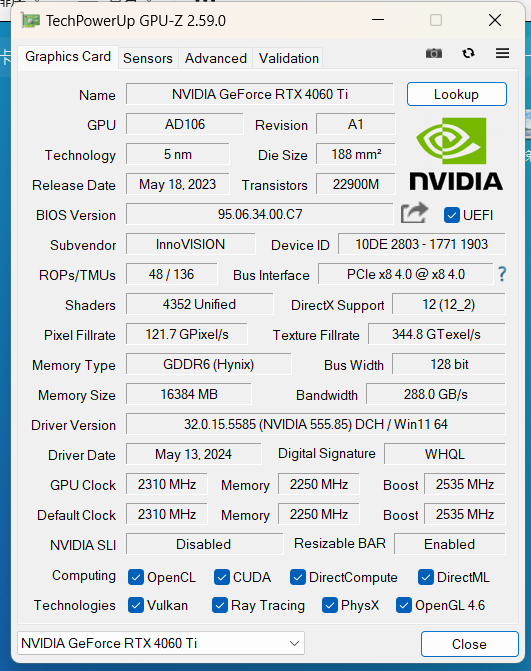

一、硬件需求

| 量化等级 | 最低 GPU 显存(推理) | 最低 GPU 显存(高效参数微调) |

|---|---|---|

| FP16(无量化) | 13 GB | 14 GB |

| INT8 | 8 GB | 9 GB |

| INT4 | 6 GB | 7 GB |

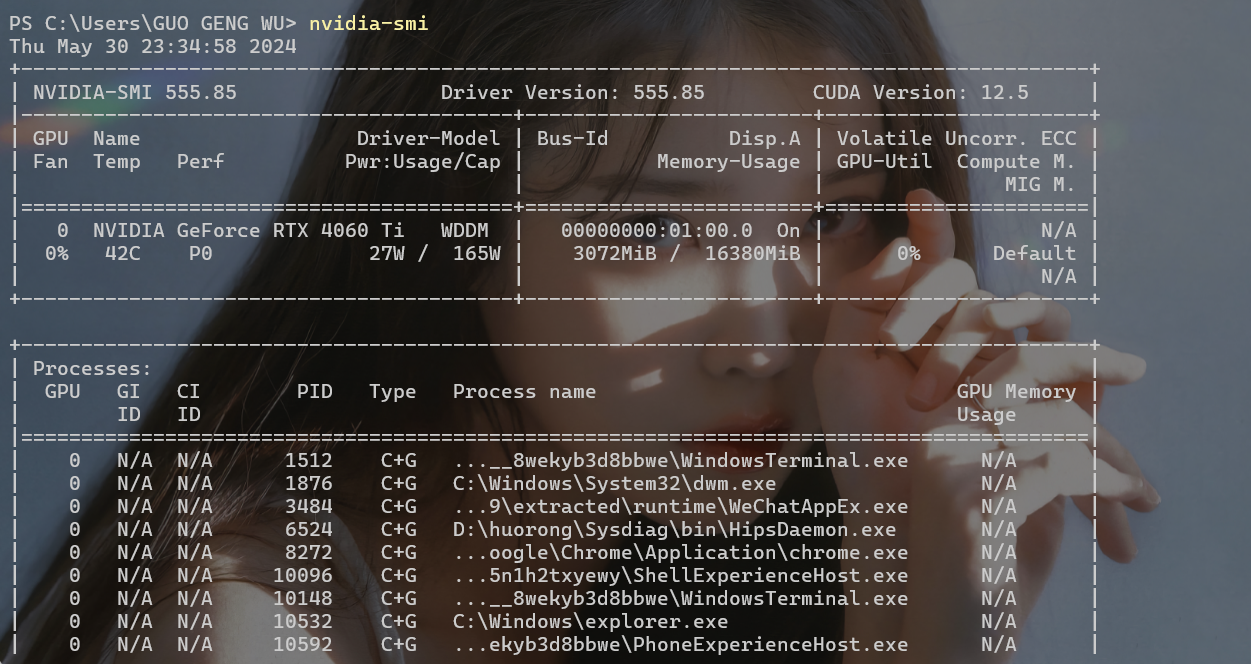

二、博主本机配置:

- 显卡:4060TI 16G基本满足配置需求

- 储存:安装模型+一些依赖项大概30多G(一个大型游戏的容量,问题不大)

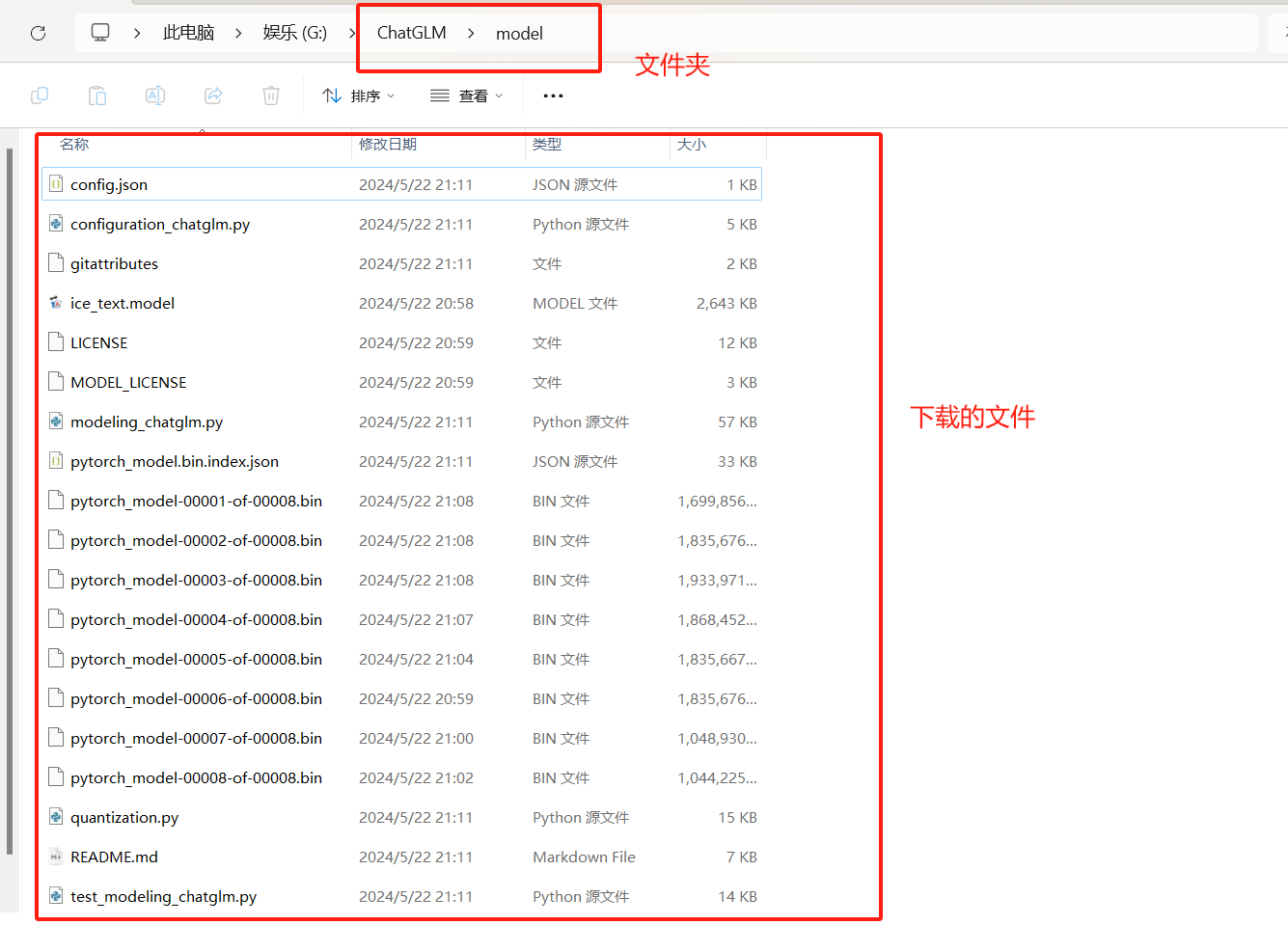

三、下载模型

- 模型文件需要在huggingface上进行下载:https://huggingface.co/THUDM/chatglm-6b

- 点击【Files and versions】即可下载文件。建议下载到一个新建文件夹中,如:创建ChatGLM文件夹,把模型文件放到 model 文件夹里(自己创建),整体结构就是/ChatGLM/model/。

- huggingface可能下载比较慢,推荐:清华云盘:https://cloud.tsinghua.edu.cn/d/fb9f16d6dc8f482596c2/

- 【注】清华硬盘只有几个模型文件(其他这个源没有的文件还是需要在 huggingface 上下载)

- 最终下载完成:

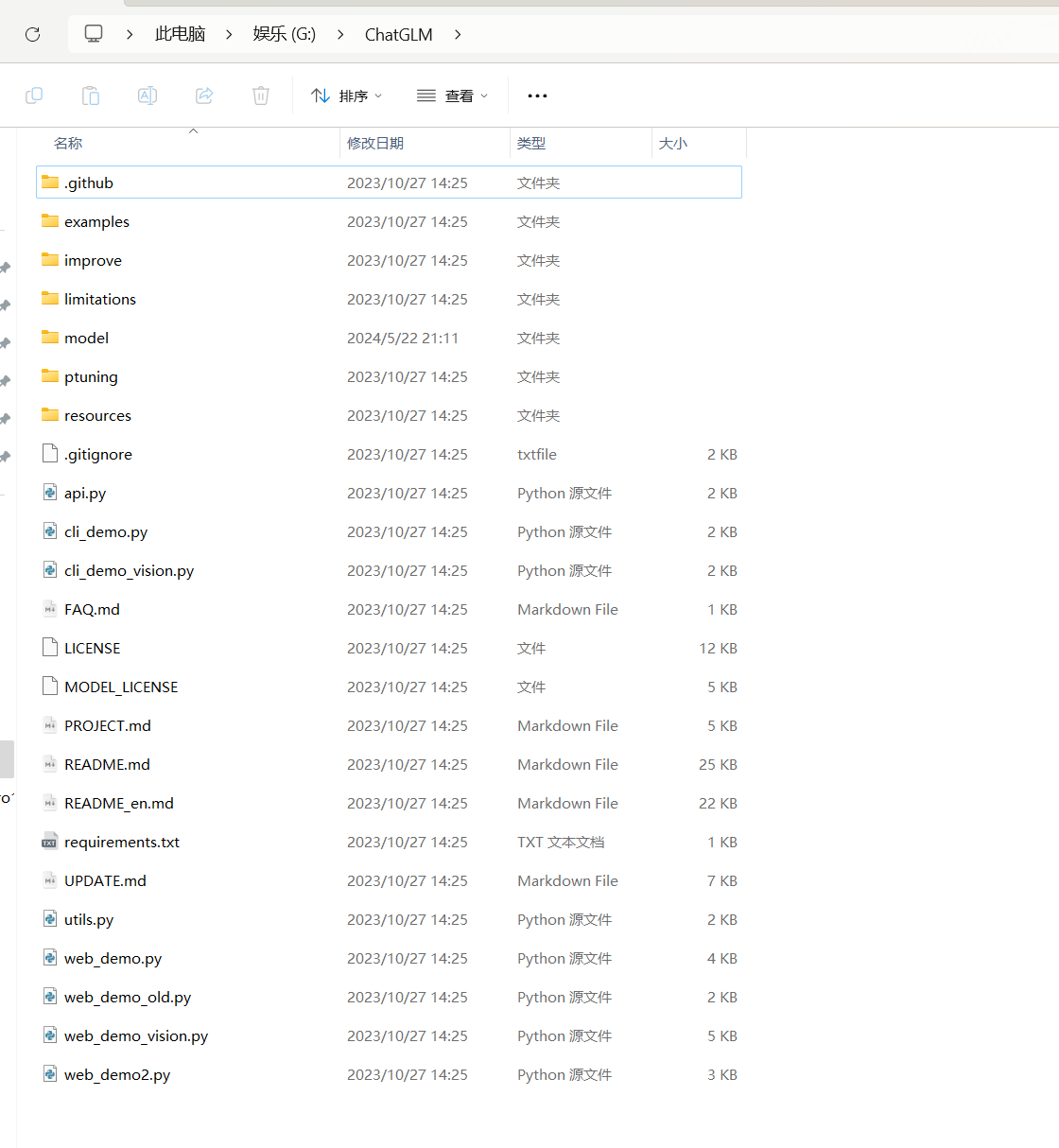

到 GitHub 中下载其他环境配置文件和 demo 程序代码。

- GitHub 地址:https://github.com/THUDM/ChatGLM-6B。下载到

- ChatGLM这个目录下即可。

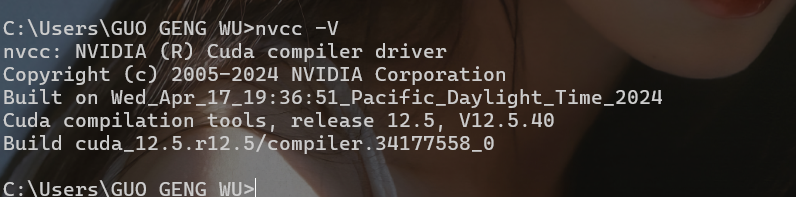

四、配置环境

- 安装自己显卡对应的 CUDA、CUDNN

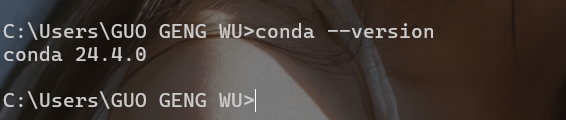

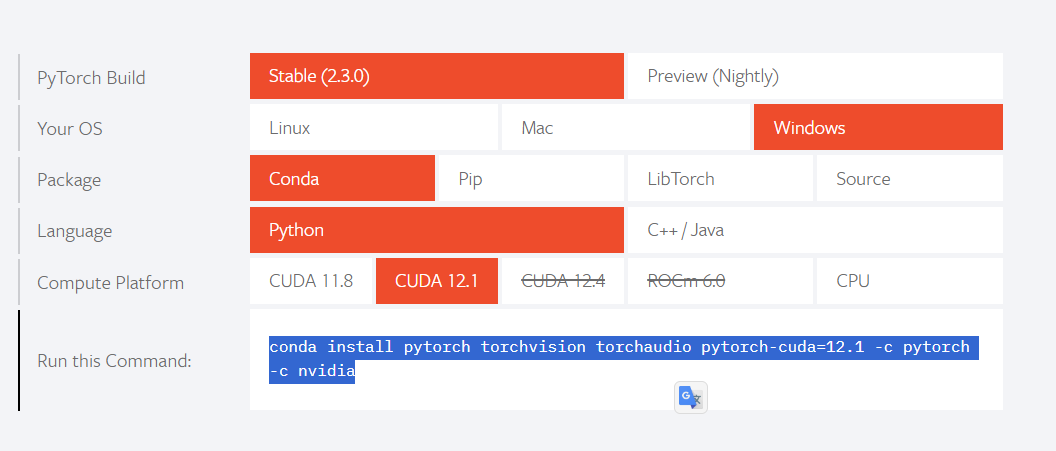

- 安装miniconda、根据cuda版本安装PyTorch(PyTorch推荐用pip安装,不然用conda装可能会影响当前python虚拟环境)

本人显卡为4060TI 16G,如果你的显卡也是NVIDIA显卡,强烈推荐看这2篇文章:

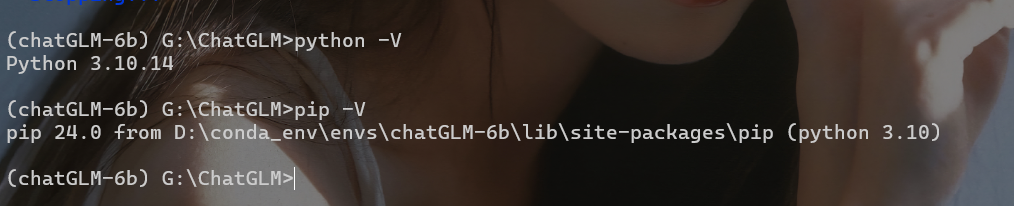

- 装好之后的样子:

在ChatGLM目录下打开命令行终端,输入下面命令,按回车后,pip 就自动下载和安装相关依赖库了。

pip install -r requirements.txt

五、使用

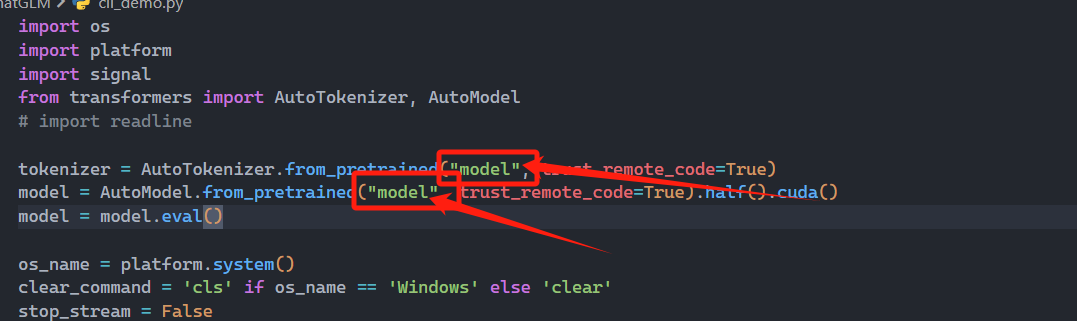

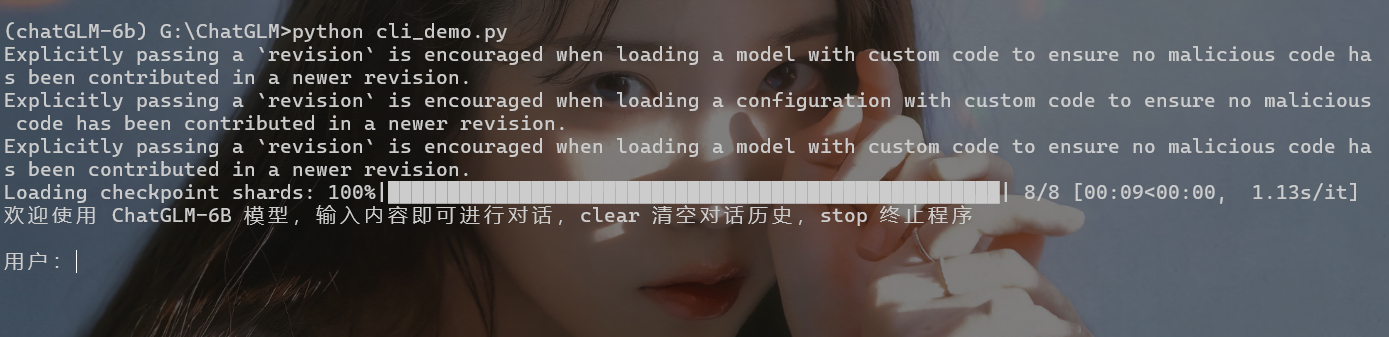

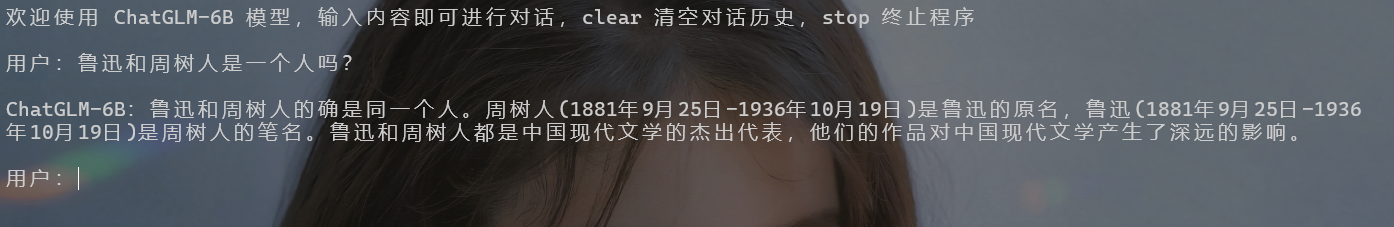

- cil demo使用:在ChatGLM目录下打开cli_demo.py文件,将原始的 “THUDM/ChatGLM-6B” 替换为 “model” 本地模型即可。如果不修改的话,会下载模型。执行 python 文件即可,可以在命令行终端输入:python cli_demo.py即可启动demo

暂无评论